Gartner说智能机器需要道德规范

阿伦·捷克利于3月20日授予第四届全国摄影奖

ITD胶结结束10%

Tata Power完成乔治亚州水电项目的金融关闭

美流行病学专家:研究显示新冠肺炎前年12月已在美传播

吉林省残联组织参观廉政教育展览

揭秘!蕴藏在吉林地名中的“红色密码”丨这里一直流传着英雄燕平的故事!

国际锐评丨美方必须回答这三个呼吁

吉林省政府最新任免一批干部

外交部:中澳关系屡遭困难责任完全在澳方 希望澳多做有利双方互信合作的事

操纵媒体、拒绝科学!世卫专家批“实验室泄漏论”迎合政治话语

外交部:美国人权劣迹罄竹难书 对他国指手画脚时不要忘记自身严重人权问题

海评面专访澳大利亚学者:“中国是经济伙伴而非竞争对手”

环球网评:谁是侵犯劳工权利的施暴者——再揭美国强迫劳动和童工黑案底

英国学者:西方对穆斯林世界犯下严重罪行 炒作涉疆议题没人信

60多国在联合国做共同发言力挺中国 外交部回应

白俄罗斯代表65国在联合国人权理事会作共同发言 反对以人权为借口干涉中国内政

“打卡”闪光点,“洋网红”用镜头展示真实、立体、全面的中国

外交部:英方绝不是人权“模范生” 也绝无资格充当别国的“教师爷”

国际奥委会委员高度赞赏2022北京冬奥会准备工作

外交部:加拿大根本没有资格指责中国人权问题 他们最该做的是反省自身劣迹

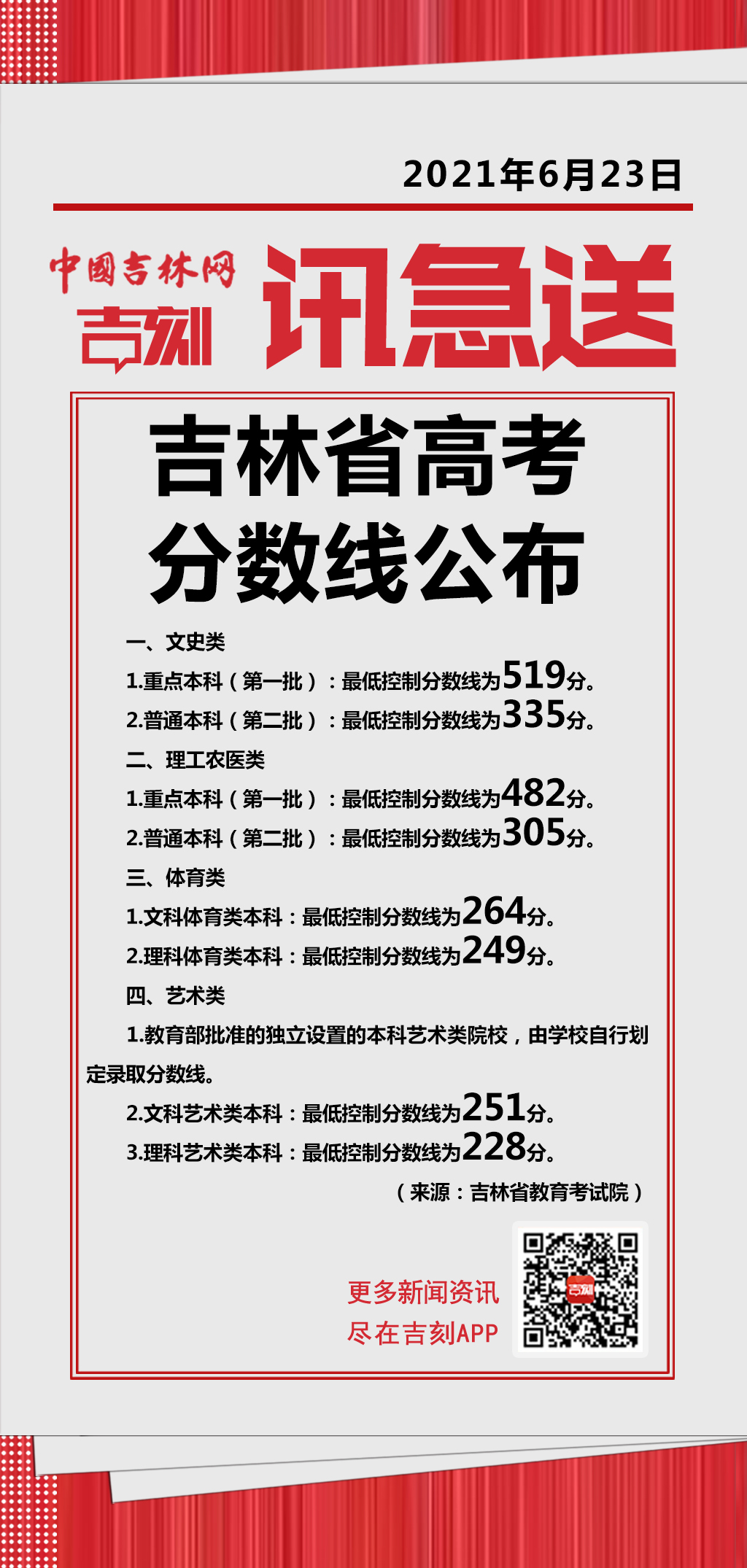

今日热榜 | 吉林省2021高考录取分数线出炉!

防疫抗疫 招商积余多点联动奋战一线

有意义!今天,长春这场“对接会”事关技术成果转化

吉林移动全面提升网络信息安全服务水平 保护人民群众利益

新疆维吾尔自治区代表:任何反华势力都无法破坏新疆安定团结的大好局面

长影旧址博物馆 国家级的电影艺术殿堂

长春市教育系统百名离退休干部举办“唱支山歌给党听”主题快闪活动

这4起超员违法行为 个个典型

大唐长春二热:全力以赴解燃煤之急保电保民生

“吉事办”为考生开通“高考成绩查询”功能!

吉林省“走出去”工作推进会在长春召开

发行业务技能(图书造型)大赛在长春市新华书店举行

5月全省畅通信访渠道,解决生态环境信访问题3383个

长春公交集团西昌汽车公司新时代文明实践站升级改造完成并揭牌

正式进军NFT 姗姗来迟的币安靠什么突围?

农业部门不太可能看到任何增长:Abhijit Sen博士

保险费:十年的希望变成了现实

WIPRO由大辛辛那提水选中,改变其CRM,计费和服务局OPS

Tech Mahindra股票以2%跌幅

随着产出升起,糖股在52周低至

德里法庭禁止格拉甘蛋白抗糖尿病药物

品牌信托报告:谷歌领先5年; Facebook瀑布; Twitter错过了公共汽车

Top Corporate News的日期 - 2015年3月25日

Oyo Rooms从Lightspeed Venture,Lemoia培养了150亿卢比

BEL计划在AP中设置武器系统设施;股票平面

拟计2015-16由Rajya Sabha清除

GMR机场在马来西亚机场增加股权64%

RBI拒绝塔塔的计划购买Docomo在Tata Tele中的股份

防守推!Premier Explosives获得8%

CIO必须开始考虑如何为智能机器制定智能机器的道德规划,根据Gartner。提高智能机器的潜力 - 确保依赖于它们的企业的成功成果 - 将遵循最值得信赖的智能机器以及它们如何维护相信。建立这一信任的核心将是人们认识和舒适的伦理价值观。“显然,

如果要接受和使用它们,人们必须相信智能机器,”Gartner的研究副总裁兼尊敬的分析师弗兰克布特敦省“获得信任的能力必须是实施人工智能(AI)或智能机器的任何计划的一部分,并且将成为营销这项技术的重要销售点。CIO必须能够监控智能机器技术,以便出于公共使用的意外后果,并立即回应,拥抱不可预见的积极成果和反击不良

的。“为了确保智能机器在道德上表现并应得我们未来的信任,CIO必须为道德讨论做好准备和编程。Gartner根据道德的影响确定了五个层次的编程和系统开发:等

级0:非伦理

编程:在此级别,没有明确的道德考虑技术的行为。该技术制造商承担了非常有限的道德责任,除了技术必须安全地提供应有的功能和可靠地提供所承诺的

功能。实施例包括“蒸发器”(一项技术宣布向公众宣布,但从未交付),这可以减少客户信任的制造商。任何软件的第一个版本很少完成,这意味着客户对“1.0版”软件的预期有限.Gartner建议技术制

造商公开沟通,他们将在其交付和任何不断变化的情况下,改变可以交付的内容以及无法提供的内容。这应包括服务级别协议(SLA),用于指定交付的内容和纹

理1:道德监

督下一代复杂程度没有道德规范,但技术部署和使用可能具有道德后果。可以使用智能机器,但它基本上是用户对结果所做的事情。主要道德责任在于使用智能机器的人手中。一些公司已经建立了

道德委员会和一些最终用户组织 - 特别是在金融服务中 - 也建立了这样的委员会,但他们是一个小少数民族.Gartner

建议组织建立了确保没有法律被破坏的治理做法,作为最低限度。他们还应该通过识别和讨论通过使用新技术构成的困境来使道德成为治理的一部分.LEVEL

2:现在正在

探索伦理编程,目前正在探索下一级复杂程度,因为正在引入智能机器,例如虚拟个人助理(VPA)。这里,用户透视图大大变化。虽然在级别0和1中,用户通常是执行作业的商业专业人员,在2级,用户通常是客户,公民或消费者

。用户,服务提供商和设计者之间共享。用户负责他们开始的交互的内容(例如搜索或请求),但不适用于他们接收的答案。设计师负责考虑技术使用的意外后果(在原因内)。服务提供商有明确的责任以道德方式与用户互动,同时正确地教导技术,并监控其使用和行为。

例如,在过去的基于智能手机的虚拟个人助理指导您到最近的桥梁你告诉过你“D喜欢跳下一个。现在,它被编程为拾取此类信号并将您推荐给帮助行。这种变化强调了Gartner的建议,以监测技术的出于意外后果的技术,并相应地回应.LEVEL

3:进化伦理编程

这一级别将道德规划为学习和发展的机器的一部分引入了道德规范。较智能机器越多,它就越远离其原始设计,其行为越多。在此级别,用户的概念再次更改。在2级,用户仍然控制,但在3级,许多任务是外包并通过智能机器自主地执

行。用户拥有的责任越少,对采用智能机器的信任越多。例如,如果您不信任您的虚拟个人助理以费用报告,则赢得“T授权它代表您行事。如果你不相信你的自主车辆驾驶山口,你就会在这种情况下重新控制。鉴于智能技术对社会的影响,3级需要相当多的新规则和立法.Gartner

建议作为长期规划的一部分,CIO考虑其组织如何代表业主对业主行为的自治技术。例如,如果智能机器能够访问员工的个人或公司信用卡,甚至有自己的信用卡?4

级:机器开

发的EthicsGartner不会期望智能机器在需要计划的时间范围内自我意识到。但是,4级预测智能机器最终将变得自我意识。他们需要提出和教导,他们的道德规范需要进化。在4级,“用户”的概念已经消失。我们只留下了“演员”的概念,他们发起了交互,回应和适应

。一个智能机器,自我意识并能够反映,是对自己的行为负责。“

我们应该问自己的问题是:我们将如何确保这些机器坚持职责?我们会像宠物一样对待智能机器,拥有所有者负责吗?或者我们会像孩子一样对待他们,直到他们能够对自己负责致敬吗?“Buytendijk先生说。

如果要接受和使用它们,人们必须相信智能机器,”Gartner的研究副总裁兼尊敬的分析师弗兰克布特敦省“获得信任的能力必须是实施人工智能(AI)或智能机器的任何计划的一部分,并且将成为营销这项技术的重要销售点。CIO必须能够监控智能机器技术,以便出于公共使用的意外后果,并立即回应,拥抱不可预见的积极成果和反击不良

的。“为了确保智能机器在道德上表现并应得我们未来的信任,CIO必须为道德讨论做好准备和编程。Gartner根据道德的影响确定了五个层次的编程和系统开发:等

级0:非伦理

编程:在此级别,没有明确的道德考虑技术的行为。该技术制造商承担了非常有限的道德责任,除了技术必须安全地提供应有的功能和可靠地提供所承诺的

功能。实施例包括“蒸发器”(一项技术宣布向公众宣布,但从未交付),这可以减少客户信任的制造商。任何软件的第一个版本很少完成,这意味着客户对“1.0版”软件的预期有限.Gartner建议技术制

造商公开沟通,他们将在其交付和任何不断变化的情况下,改变可以交付的内容以及无法提供的内容。这应包括服务级别协议(SLA),用于指定交付的内容和纹

理1:道德监

督下一代复杂程度没有道德规范,但技术部署和使用可能具有道德后果。可以使用智能机器,但它基本上是用户对结果所做的事情。主要道德责任在于使用智能机器的人手中。一些公司已经建立了

道德委员会和一些最终用户组织 - 特别是在金融服务中 - 也建立了这样的委员会,但他们是一个小少数民族.Gartner

建议组织建立了确保没有法律被破坏的治理做法,作为最低限度。他们还应该通过识别和讨论通过使用新技术构成的困境来使道德成为治理的一部分.LEVEL

2:现在正在

探索伦理编程,目前正在探索下一级复杂程度,因为正在引入智能机器,例如虚拟个人助理(VPA)。这里,用户透视图大大变化。虽然在级别0和1中,用户通常是执行作业的商业专业人员,在2级,用户通常是客户,公民或消费者

。用户,服务提供商和设计者之间共享。用户负责他们开始的交互的内容(例如搜索或请求),但不适用于他们接收的答案。设计师负责考虑技术使用的意外后果(在原因内)。服务提供商有明确的责任以道德方式与用户互动,同时正确地教导技术,并监控其使用和行为。

例如,在过去的基于智能手机的虚拟个人助理指导您到最近的桥梁你告诉过你“D喜欢跳下一个。现在,它被编程为拾取此类信号并将您推荐给帮助行。这种变化强调了Gartner的建议,以监测技术的出于意外后果的技术,并相应地回应.LEVEL

3:进化伦理编程

这一级别将道德规划为学习和发展的机器的一部分引入了道德规范。较智能机器越多,它就越远离其原始设计,其行为越多。在此级别,用户的概念再次更改。在2级,用户仍然控制,但在3级,许多任务是外包并通过智能机器自主地执

行。用户拥有的责任越少,对采用智能机器的信任越多。例如,如果您不信任您的虚拟个人助理以费用报告,则赢得“T授权它代表您行事。如果你不相信你的自主车辆驾驶山口,你就会在这种情况下重新控制。鉴于智能技术对社会的影响,3级需要相当多的新规则和立法.Gartner

建议作为长期规划的一部分,CIO考虑其组织如何代表业主对业主行为的自治技术。例如,如果智能机器能够访问员工的个人或公司信用卡,甚至有自己的信用卡?4

级:机器开

发的EthicsGartner不会期望智能机器在需要计划的时间范围内自我意识到。但是,4级预测智能机器最终将变得自我意识。他们需要提出和教导,他们的道德规范需要进化。在4级,“用户”的概念已经消失。我们只留下了“演员”的概念,他们发起了交互,回应和适应

。一个智能机器,自我意识并能够反映,是对自己的行为负责。“

我们应该问自己的问题是:我们将如何确保这些机器坚持职责?我们会像宠物一样对待智能机器,拥有所有者负责吗?或者我们会像孩子一样对待他们,直到他们能够对自己负责致敬吗?“Buytendijk先生说。

免责声明:本网站所有信息仅供参考,不做交易和服务的根据,如自行使用本网资料发生偏差,本站概不负责,亦不负任何法律责任。涉及到版权或其他问题,请及时联系我们。